定义:游戏图标风格模型包含的图标属性类目多,杂。训练集各个属性数量占比不均衡,在游戏中往往宝箱、宝石、药水瓶、卡券占多数,所以这类风格模型在工作流的运用上通常是用来做风格迁移。

因为训练素材各个占比数量不同,也就导致造型上数量多的在训练轮数增加会被固化,很难通过补充形状的提示词来做造型上的改变。而恰恰因为某些训练素材占比少,轮数增加之后反而能够获得稳定的效果。结论就是风格模型 LoRa 没有绝对的稳定的单一模型,需要依据需求使用不同轮数的模型来做生产。

关于打标

如果是训练风格模型,没必要给各个素材打统一的触发词,应该是将每个素材标按:属性+特征描述 例如:gift box,flower,ribbons,bow,

如果是训练专属某个属性的图标模型,例如头像框则要分析当前头像框的素材造型特征。头像框算是比较简单的造型了,大体上分为对称设计和不对称设计两种。所以在打标的时候要加入 symmetry、asymmetrical 两个标签,扯远了……

补充训练集

一个游戏项目的图标资产数量上肯定是有限的,甚至某些数量还不满足训练要求。这时候就要有目的性地去从外部补充素材,筛选风格相似、写实度大体接近的进行补充。

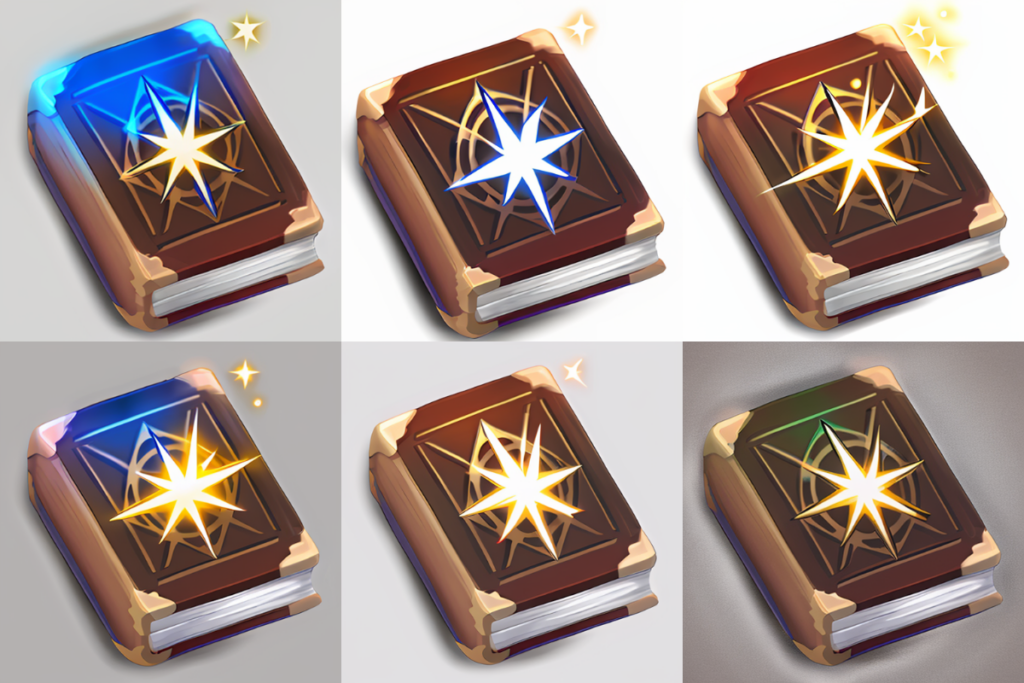

例如上图的书籍图标样式大体类似,通过补充一些其他造型、角度不同的书籍图标来让它更具泛化性,从而满足需求。

例如礼盒图标也是因为训练素材太过单一的缘故,细节造型上缺少一些变化。为了扩充礼盒的泛化能力有目的性地去补充了相关训练素材。

下图是补充后的

例如宝石,原来的宝石也是缺少一些变化,造型上太单一,缺设计感。

补充的素材之后

风格模型的价值在于能够涵盖泛的图标造型,同时继承游戏项目的风格,造型上不追求精确,具备可修改的空间,满足在图标的批量生产中的风格迁移即可。

关于生成的图标出现污染的问题

如图水果冰激凌会出现叶子和面包等类型的元素,是因为打标的时候加入了food这个标签的影响,所以迭代模型的时候可以将相应的素材打标要清理干净,虽然都是食物,但要精细化去打标。

没有被打标污染的食物图标

以上图标基础模型:revAnimated_v122EOL 训练而来,训练集数量674

![[DALL·E 3]算是最易用的自然语言绘画](https://trilightlab.com/wp-content/uploads/2024/01/截屏2023-07-25-20.59.26.png)

![[stable diffusion]浅谈AI游戏道具-在项目中的运用](https://trilightlab.com/wp-content/uploads/2024/01/064515616.png)