在训练Dreambooth-XL模型中,4090和3090已经是大部分普通设计师能够使用的显卡训练了,训练Dreambooth比训练lora需要更多的训练集,同时Dreambooth模型支持更多的概念同时训练,而lora更多是解决单一概念的风格微调。

这就导致更多的训练集需要更多的步数才能拟合,也就对训练的显卡显存有更高的要求。

本文分享一个能够针对Dreambooth-XL模型训练优化参数节省显卡显存并降低训练时间的方法。我在这里主要是修改了三个地方:

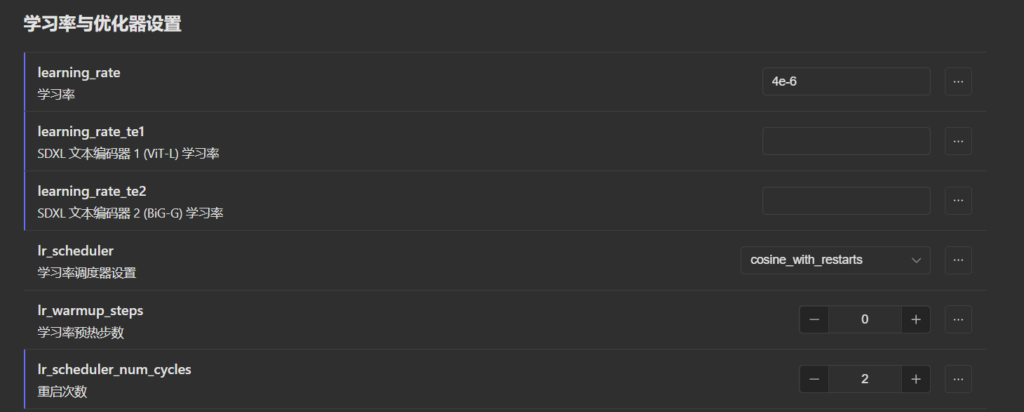

我的训练集为622张,最大轮数为30epochs,修改batch_size参数为4,这样可以加快训练速度。

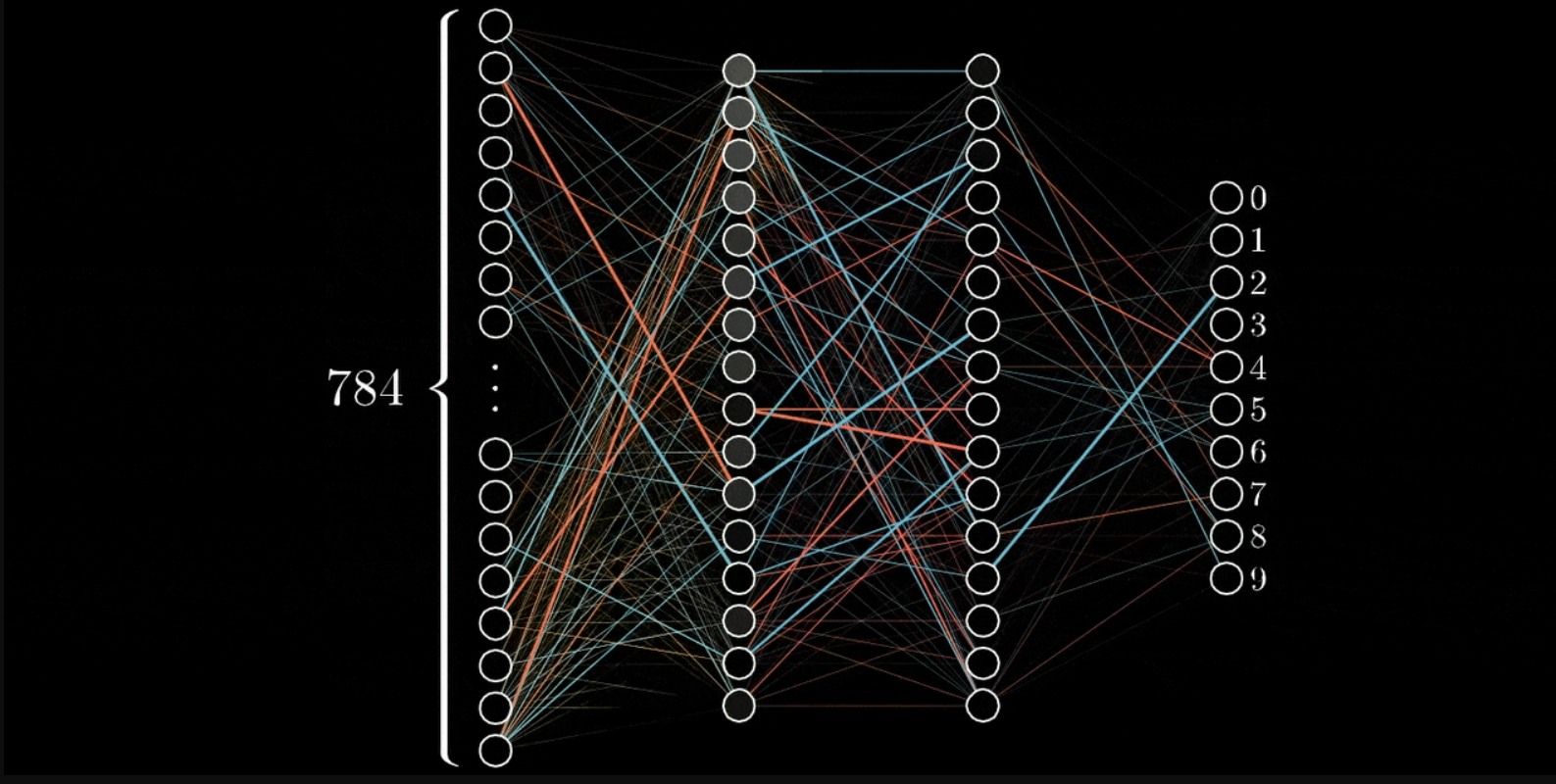

如果你不打算训练lr文本编码器(也就是不再赋予模型更多的语言理解能力),可以将lr的学习率直接去掉,仅训练模型的Unet部分。

同时将开启余玄重启次数为2,开启梯度检查点。

将以上参数设置好之后就能顺利开启训练:

以上为3090ti的显卡配置,去掉文本编码器的学习率将batch-size:改成 4

如果你不需要模型赋予更多的语言理解能力,可以参考以上参数进行调整。

以上参数的调整证明了修改以上参数能够将batch-size改成4并且能够正常训练(不做修改则只能将batchsize调整成1,否则会终止训练并报错),减少了学习步数,加快的训练速度。