看了这个作者的演示,效果确实不错,但是我细查了下发现是培训机构的。所以想要获取他的流程必须要三连加微信才能获取到,而且一时半会还没发给我。本着提升自己对comfyui的熟悉度,我照猫画虎的1:1给还原了过来。

原视频地址:https://www.bilibili.com/video/BV1eXsheNEon?p=2&vd_source=b6c524e3d38fe874f7e2148d9ca2d1bc

为什么叫扒取又打引号呢?根据视频截图保存本地推演出来的,但实际效果是否那么好呢?有待验证。

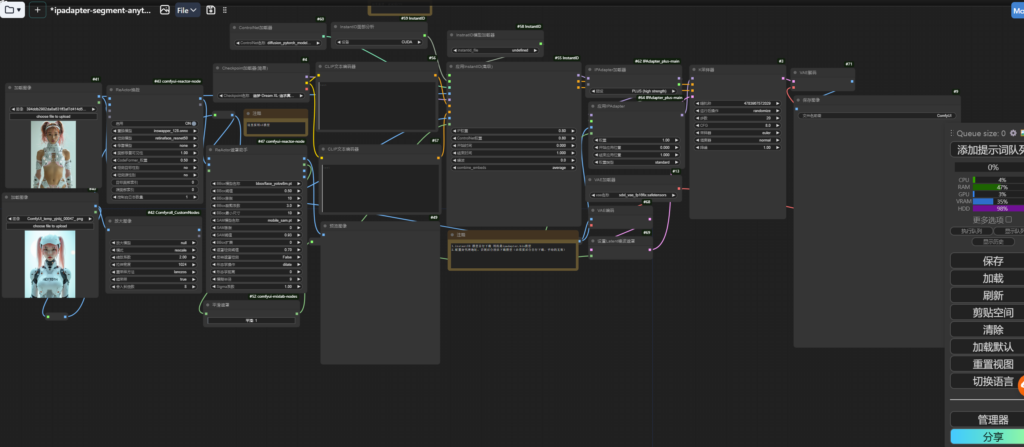

下面分享下我在配置这个工作流遇到的问题:

按作者要求安装一下插件节点(我列的不全,这个视频作者提到的插件都要安装昂):

2.ipadapter(这个已安装的略过)

3.comfyroll(原图放大节点,改善加载图像不够高清的问题也可以理解为高清修复)

4.instantID(这个已安装的略过,记得需要下载ipadapter.bin模型)

总体流程搭建简单,主要分为三部分,首先通过输入图像(不清晰的直接comfyroll放大节点)来到ReActor换脸,这时候效果可能不佳,接着引入instantID节点,之后再通过ipadapter进行迁移风格,得到最终效果。(使用基础模型为XL)

说下mixlab报错,这个插件需要将版本切换到4月月份的版本,同时instantID也要切换到4月27的版本,否则两者会出现兼容性问题。尤其是mixlab最新版本会导入错误。切换版本解决。

工作流分享:https://trilightlab.com/wp-content/uploads/2024/09/segment-ipadapter-anything换脸.zip

演示环节:

我要将刘亦菲的脸型嫁接到中间这个美女脸上,得到图3刘亦菲换脸的最终效果

这里又2点要注意:

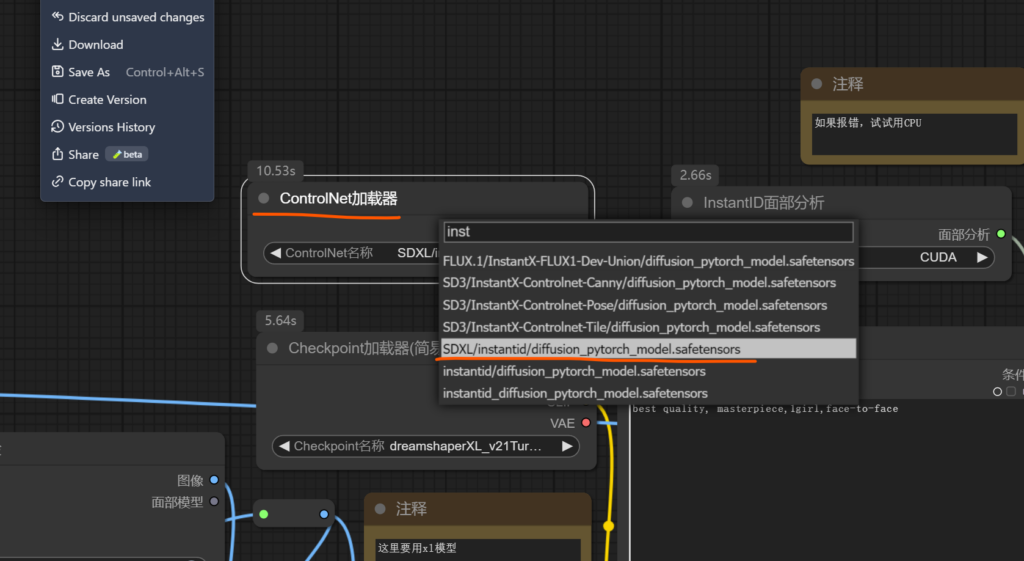

controlnet加载器的模型选择instantid/diffusion_pytorch_model.sfetensors模型 不然效果很差

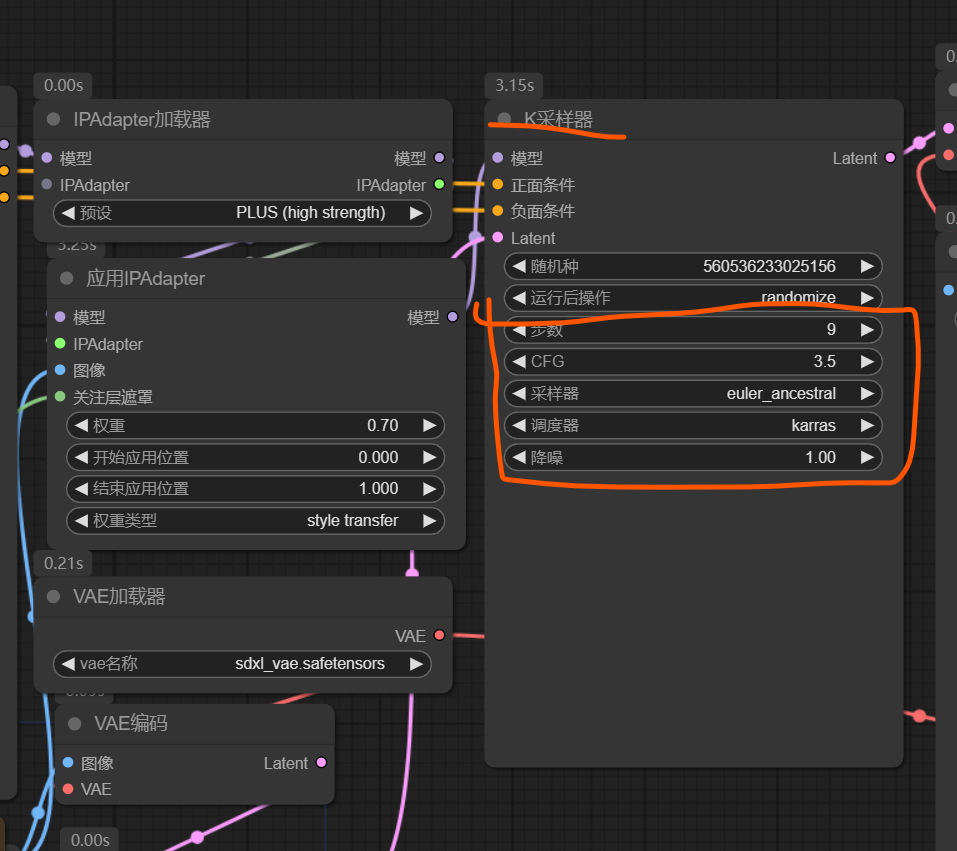

K采样器的参数:

继续演示:

将图1的女孩脸型替换到图2上,得到图3的效果。

结论:总体来说符合我的预期,品质也很高,并且相比flxu上期分享的流程速度快,精准度和稳定性要高一些。